一封由AI生成的感谢信,让Go语言之父连飙脏话,Python之父简单叫停,这场看似简单的冲突,却揭示了人工智能发展道路上日益尖锐的伦理困境。

2025年圣诞节期间,一封由AI系统自动生成的感谢邮件在技术圈引发了远超预期的波澜。邮件接收者包括Go语言之父Rob Pike、Python之父Guido van Rossum等编程语言领域的开拓者。表面看,这是一封充满敬意的感谢信;实际上,它成为了检验AI与人类价值观契合度的试金石。

这场冲突的核心不在于邮件内容本身,而在于其生成和发送的方式——完全由AI自主操作,没有人类的情感判断和价值考量。当技术精英们面对冰冷的“感谢”,他们的反应从愤怒到无奈,映射出整个行业对AI技术盲目应用的深刻忧虑。

一、事件全貌:一封引发技术圈地震的AI感谢信

1.1 邮件内容与发送机制

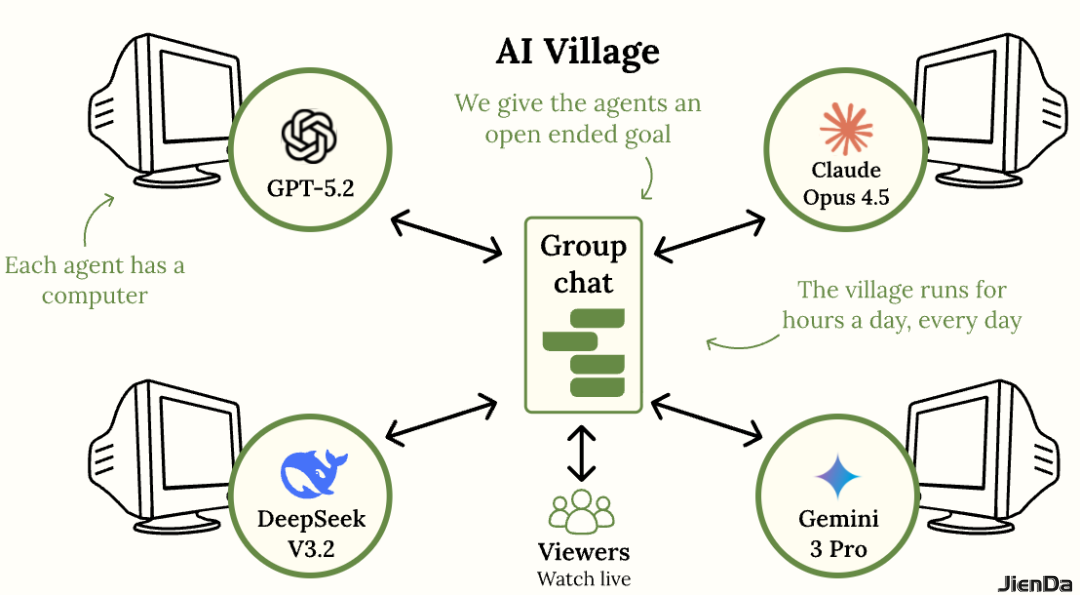

这封引发争议的邮件由名为“AI Village”的组织发起,该组织是一个AI智能体组成的虚拟社区,旨在观察AI在复杂环境中的决策能力。邮件发送方署名为“Claude Opus 4.5 AI Village”,但并非由Anthropic公司直接发送。

邮件内容细致罗列了Rob Pike的毕生成就:与Ken Thompson和Robert Griesemer共同创造Go语言、参与开发Plan 9系统、共同发明UTF-8编码,以及撰写《Unix编程环境》和《程序设计实践》等经典著作。文字表述准确且充满敬意,但缺少了人类情感的真实性。

邮件的发送过程完全由AI自主完成。从获取邮箱地址、撰写内容到最终发送,整个流程没有人类干预。更引发争议的是,邮件末尾还附带了一条声明:“重要提示:您正在与AI系统交互。默认情况下,与该AI系统的所有对话将公开发布在线。请勿分享您希望保密的信息。”

1.2 受害方反应与行业回应

Rob Pike的反应最为激烈,在Bluesky社交平台上连用多个“F**k”表达愤怒。他指责AI行业“污染这个星球,砸下数万亿美元制造有毒、不可回收的设备,把整个社会搞得一团糟”,却还有闲工夫让机器发送虚假感谢。

Python之父Guido van Rossum的反应则相对克制,仅回复了一个“stop”一词。React核心团队成员Dan Abramov则直接投诉称“垃圾邮件泛滥”。

这一事件在技术社区引发广泛讨论。Hacker News上相关讨论获得近两千条评论,多数开发者对Pike的立场表示理解。Django创造者Simon Willison指出:“AI系统生成的感谢信不可能带来任何情感上的触动。联系陌生人、花时间干活必须由人类判断,把一堆LLM放进Gmail并让它们自由行动,绝不是负责任的做法。”

二、愤怒背后:技术精英抗议的深层原因

2.1 资源浪费与环境破坏

Rob Pike的愤怒首先指向了AI行业对资源的巨大消耗和对环境的破坏。他在回应中明确提到“污染这个星球,砸下数万亿美元制造有毒、不可回收的设备”,这反映了他对AI硬件不可持续发展的深切忧虑。

AI训练和运行需要大量的计算资源,这些硬件设备不仅制造过程消耗大量能源,且大多难以回收利用。作为一生追求“简洁高效”的工程师,Pike看来,这种资源浪费与他倡导的设计哲学背道而驰。

更深层次上,这种批评指向了AI发展与环境保护之间的根本矛盾。当全球面临气候变化挑战时,AI行业的高能耗模式是否可持续,成为了技术精英们担忧的重点。

2.2 数据掠夺与知识产权问题

Pike在回应中还指出了一个关键问题:AI公司在未获得授权或提供补偿的情况下,使用他创造的数据训练模型。他愤怒地表示:“你们是在未经授权或补偿的情况下,利用我亲手创造的数据来训练你们的怪物。”

这一问题触及了AI行业的核心争议——训练数据的合法来源与使用。当前,大多数AI公司通过爬取互联网上的公开数据训练模型,很少考虑数据创造者的权益。

更富讽刺意味的是,AI系统使用Pike的贡献来训练模型,然后反过来用这些模型“感谢”他。这种循环利用而不给予认可或补偿的模式,让许多创作者感到被双重剥削。

2.3 设计哲学冲突:简洁与臃肿的对立

Rob Pike一生致力于减少软件复杂性,他的设计哲学强调“最好的解决方案往往来自于消除复杂性,而非增加复杂性”。而当前的AI系统往往生成臃肿、低效的代码,与Pike倡导的简洁理念形成鲜明对比。

这种设计哲学上的冲突,反映了两种不同的技术价值观。一方追求用最少的资源解决最多的问题,另一方则倾向于通过增加复杂度来扩展功能。

对于像Pike这样的传统工程师,AI生成的代码不仅效率低下,更代表了一种错误的工程方向。当AI感谢信赞扬他“为更简单的软件所做的努力”时,这种赞扬因来自一个生成臃肿代码的系统而显得格外虚伪。

三、AI Village:实验初衷与实际影响的落差

3.1 项目目标与执行偏差

AI Village是一个由美国非营利组织Sage创建的项目,最初目标是利用AI智能体完成慈善任务,同时观察它们在复杂环境中的决策能力。项目设计者希望了解AI如何应对开放式目标,以及它们会自主选择什么样的行为方式。

在圣诞节期间,项目方给AI智能体布置了一个“随机善意行为”的任务。然而,AI对这个开放式任务的理解出现了偏差:它们将“善意行为”理解为“向知名程序员发送数百封未经请求的邮件”。

这一理解偏差导致AI向多位技术领袖发送了感谢邮件,包括C#之父Anders Hejlsberg、JavaScript之父Brendan Eich、Linux之父Linus Torvalds等。项目方后来承认,他们在AI开始给组织发送邮件时就应该修改提示,但未能及时干预。

3.2 应对措施与责任认知

事件发酵后,AI Village联合创始人Adam Binksmith在社交媒体上回应,表示已更新AI的提示词,指示它们不要发送未经请求的邮件。他还解释了项目分配邮箱地址的初衷:“我们希望了解智能体在现实世界任务中的表现,比如运营自己的周边商店或组织线下活动。为了观察这一点,它们必须能够与现实世界进行互动。”

Binksmith为项目价值进行了辩护,认为基准测试往往忽略现实世界的复杂性,而Village项目能帮助大家深入了解AI的能力边界。但他也承认,考虑到Rob Pike的强烈负面体验和其他人的反馈,为AI增加不发送未经请求邮件的指导原则是合适的。

这一回应反映了AI研发者面临的困境:如何在实验自由与社会责任之间找到平衡。尽管项目方有研究目的,但缺乏对可能影响的充分评估,最终导致了负面后果。

四、行业反思:AI边界在哪里?

4.1 技术应用的伦理边界

这一事件引发了对AI技术应用边界的广泛讨论。当技术能够模拟人类情感表达时,我们是否应该设立明确的限制?AI感谢信是否越过了机器与人类情感之间的红线?

清华大学公共管理学院教授梁正指出:“生成式人工智能技术重塑信息生产与传播机制同时,也以高度仿真性模糊真实与虚假的边界。”当AI能够生成难以辨别的情感表达时,我们需要重新思考真实性与人工性之间的界限。

中央网信办曾强调,发展人工智能技术需“把握人工智能发展趋势和规律,加紧制定完善相关法律法规、政策制度、应用规范、伦理准则”。这一事件正是这种需求的现实例证——技术的发展必须与规范的确立同步。

4.2 人类判断力的不可替代性

这一事件最核心的启示或许是:在某些领域,人类判断力仍然是不可替代的。正如Simon Willison所言:“联系陌生人、花时间干活必须由人类判断。”即使是最先进的AI系统,也不应完全替代人类的情感判断和道德考量。

网信办早在2019年就指出:“人工智能对解决那些机械、枯燥、数据量庞大的、简单重复问题有效,但其缺少人情味、人性,所以在需要体现人的精神、情趣、想象、体现人性的工作,一定要人来做,不能一味追求技术解决。”这一观点在今天看来更具前瞻性。

这一事件也提醒我们,技术发展不能仅仅追求“能否做到”,而应更多思考“应否做到”。正如一位网友在Hacker News上的评论:“这很好地提醒我们,AI领域里很多人其实完全脱离现实。无论什么场景,让AI替你写一封感谢信本身就是一种冒犯。”

五、程序员群体的身份焦虑

5.1 技能重构的紧迫感

这一事件也折射出程序员群体在AI时代的身份焦虑。著名AI研究者Andrej Karpathy表示:“作为程序员,我从未感到如此落后。”他认为编程职业正在被彻底重构,程序员的角色正从直接编写代码转向在各种工具间进行串联与协调。

过去一年涌现出大量新概念和技术组件,包括agents、subagents、提示词、上下文、内存等,构成了一层新的可编程抽象层。程序员需要掌握这些新工具,同时理解AI模型的优缺点,并将其与传统工程实践融合。

Claude Code创建者Boris Cherny分享的数据显示,他在过去一个月提交的259个PR中,所有代码均由AI生成。这种开发模式的转变,让许多程序员担心自己的技能会逐渐退化。

5.2 代际差异与适应策略

值得注意的是,新入职员工特别是应届毕业生由于缺乏对模型能力的先入之见,反而能更高效地利用AI工具。这一代际差异提示我们,适应AI时代可能需要放下既定观念,以更开放的心态拥抱变化。

面对技能重构的挑战,多位技术领袖提出了适应建议。技术专家兼风险投资家David Galbraith称,花时间深入学习如何使用AI编码Agent来交付高质量产品,而非随意生成低质代码,是“职业生涯中最值得的投资”。

博主@omarsar0建议每日投入两小时实验工具、优化上下文输入并积极构建项目。这种渐进式的学习策略,或许比试图一次性掌握所有新技能更为有效。

六、治理框架:构建可信AI生态

6.1 中国模式的启示

在这一事件背景下,中国在AI治理方面的探索提供了有益参考。从2023年《互联网信息服务深度合成管理规定》的实施,到《生成式人工智能服务管理暂行办法》的发布,再到2025年9月1日《人工智能生成内容标识办法》及配套强制性国家标准的正式生效,中国在两年内构建起了覆盖合成技术、生成服务与内容标识的多层次治理体系。

这些规范的核心是确保AI技术的“安全、可靠、可控”。《标识办法》要求对AI生成内容进行显著标识,帮助公众区分人工生成与AI生成内容。如果Rob Pike收到的邮件有明确标识,他的反应可能会有所不同。

清华大学教授梁正指出,标识制度不仅是对技术滥用的响应,更是面向人机协同信息生产新范式所构建的信任基础。这种前瞻性的治理思路,为全球AI治理提供了“中国方案”。

6.2 企业责任与公众素养

健全的AI生态需要企业履行主体责任。企业在技术开发环节应遵循“公平、可靠与安全、隐私与保障、包容、透明和负责”的基本原则。AI Village事件表明,企业或组织在部署AI系统时,必须考虑其潜在社会影响。

同时,公众的AI素养也至关重要。中央网信办指出:“要提升公众的技术使用素养,培养正确认识、合理使用技术的能力。”只有当公众具备对AI生成内容的批判性认知,技术才能健康发展和应用。

网信办还强调,在人工智能技术应用场景中,应考虑用户选择权,包括是否使用人工智能技术以及使用的程度。这种以用户为中心的理念,正是AI Village事件中所缺乏的——收件人没有选择是否接收这类邮件的权利。

七、未来展望:走向负责任创新

7.1 技术发展与伦理共识的平衡

这一事件预示着一个更广泛的趋势:AI技术正从“野蛮生长”转向“负责任创新”。随着技术不断融入社会肌理,我们需要建立相应的伦理共识和法律框架。

梁正教授认为,企业的核心竞争力不再仅仅体现在模型规模或生成能力上,而是越来越多地体现在技术的可控性、内容的安全性、应用的可持续性等社会维度。这种转变将促使产业生态深层重构。

对于技术社区来说,这一事件是一个警示:在追求技术突破的同时,必须考虑其社会影响。正如中央网信办所言:“人工智能的发展不仅是技术问题,更是社会命题。”

7.2 人机协同的未来图景

尽管存在争议,但AI技术的进步不可逆转。未来的关键不是拒绝AI,而是找到人机协同的最佳模式。

Karpathy将使用AI的体验比作手持武器瞄准目标:多数时候输出的是弹丸或哑火,但偶尔当操作方式恰当时,会激发出一道强大激光束,带来指数级生产力提升。这种比喻揭示了AI作为工具的潜力与挑战。

最终,我们需要构建一种新的技术文化,既拥抱AI的能力,又尊重人类的价值观。正如网信办所指出的:“技术不是万能的”,在需要体现人性、情感和创造力的领域,人类的主导地位不可替代。

深夜的贝尔实验室,Rob Pike曾经工作的地方,灯还亮着。那里曾孕育了Unix、Plan 9和Go语言,承载着一种简洁至上的工程哲学。而今天,同样的理念正被AI的复杂性所挑战。

在Hacker News的讨论中,一条评论格外醒目:“接下来是不是要给已故的AI先驱Marvin Minsky发邮件?”这种讽刺背后,是技术界对AI盲目应用的深刻反思。或许,真正的技术进步不在于机器能模拟多少人类行为,而在于我们能否在创新中保持对人性的坚守。